j'ai fait sur ma calculatrice un petit programme permettant de tester la fonction random.

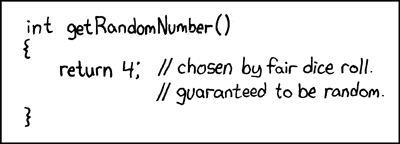

Mon but est de tester si cette fonction est belle et bien "aléatoire".

Cette fonction choisis un nombre entre 0 et 1 (exclus) avec 10 chiffres après la virgule. J'ai partagé l'intervalle de 0 à 1 en 10 parties et le programme décompte combien de fois elle tombe dans chaque.

Je ne suis pas très bon en statistique j'ai été regardé un peu sur wiki et apparemment une des meilleures mesures de dispersion est "l'écart type" (la racine carré de la variance soit la racine carré de la moyenne des carrés des écarts à la moyenne (c'est bien ça non ?)).

J'ai bien compris l'idée de cette mesure (plus l'écart type est proche de 0 plus la fonction est aléatoire et plus il en est loin, moins la fonction est aléatoire), le problème c'est : quelle est la limite à laquelle on peut dire que cette fonction sera aléatoire ou non ?? faut-il avoir un modèle de base pour comparer ?

voila les résultats du test (ce n'est pas très fastidieux car ma calculatrice est une 25+ et est TRES lente)

sur 13000 générations:

dans chaque pas de 0,1:

1348;1378;1347;1291;1289;1322;1249;1229;1287;1260

la variance est donc

L'écart type est donc de : Rac(2069.4) ~= 45.5

qu'est-ce que je peux faire avec ça ?

Merci d'avance.